こんにちは、運用技術本部 サイトオペレーションズ部の秋山と申します。

Yahoo! JAPANには日本一のサイトを支えるたくさんのネットワーク機器、サーバー、ストレージがあります。

日々増え続ける、インフラ機器の運用管理に頭を悩ませている、管理者も多いかと思います。

悩むポイントは機器管理、コスト等いくつかあるかと思いますが、今回は「サーバーの熱」に焦点を絞り、話をします。

普段使っているパソコンなどもそうですが、情報技術(IT)機器全般に電源投入後は熱を持ち、

内部のファンで、たまった熱をケース外に吐き出す構造のものがほとんどです。

パソコン1台ですと、暖かい風が出てくるだけ。というイメージが多いかと思いますが、

データセンタのようにサーバー数百~数千台を同じ部屋に置くと、部屋全体の室温が上昇し、

機器安稼働のため大型空調で部屋全体を冷ます(もしくは、ラック架列単位でシートなどで多い、吸気部分だけに冷風を送り、暖風は上部を抜け、外に出す)

のが今までの定説でした。

しかし、機器が増えるにつれ、空調の運用コスト(購入費用、電気代など)も右肩上がりで増えていきます。

そこで、これらのコストを抑えるべく、空調を止めた場合を想定し、サーバーは熱に耐えられるのか実験です。

検証条件、事前準備

- 検証ラックは前後に扉を設置し、外部の空調冷気を取り込まない、内部暖気を外へ逃がさないようにする。

- 本ラック内の温度は通常時35度。インバータ空調運転のように自動で室温コントロールはしないため、サーバー負荷時は35度以上もありえる。

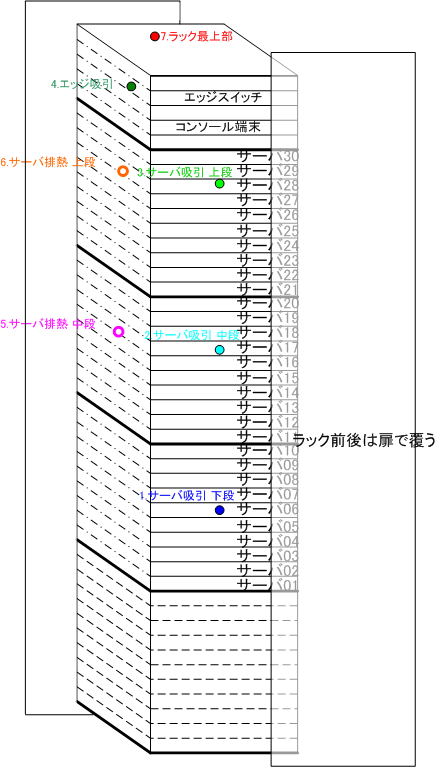

検証環境 イメージ図

※1~7はラック内センサーの位置を現しています。

Yahoo! JAPANで採用しているサーバーは、複数メーカでかつ、機種も古いものから最新のものまで多種多様です。

まずはそれぞれのサーバーが、温度上昇により自発的にシャットダウンする閾値を調べます。

ipmi sensorコマンドより

←古めの機種------新しい機種--→

A社:機種A-1 55度 機種A-2 51度 機種A-3 47度

B社:機種B-1 47度 機種B-2 47度 機種B-3 47度

C社:機種C-1 41度 機種C-2 42度 機種C-3 45度このように、各メーカで閾値がバラバラで、最大で14度の差も見受けられます。(A-1とC-1の差)

!! 注意 !!

その他にも下記機器で閾値が有ります。

盲点になりそうな物品も有りますので、検証の際は一度確認してみると面白いです。

コンセントバー 55度

電源ケーブル 60度

UTPケーブル 約60度

光パッチケーブル(屋内用) 約40度

検証結果

では実際に、サーバーに負荷をかけてみてどのような現象がおきるのか試してみましょう。

当然ですが、室温35度前後の設定でアイドル状態のサーバーは動きます。ダウンするサーバーは有りません。

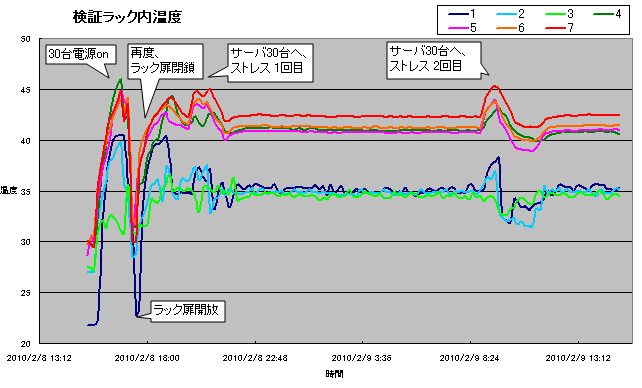

しかし、一時的に負荷をかけると、それぞれの値で温度が上昇し、ラックの上部では45度まで達します。

それではサーバーはどうでしょうか。

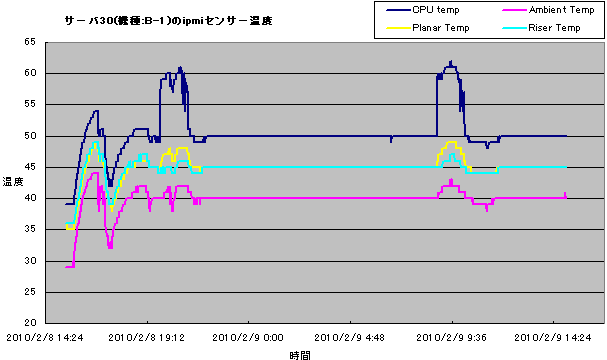

ラック内で一番温度が高いと思われる、サーバー30(機種 B-1)のipmiセンサーの温度logをグラフにしてみると、下記のようになります。

一番温度が高い時でも44度(Ambient Temp)、閾値が47度ですから、本環境での稼働に対して何も問題はありません。

そのほかに検証中の際に起きた現象について、

C-1機種が2台起動不可に。

C-2機種が5台、閾値超えによりshutdown。

A,B社の機種は、shutdown等は起きなかった。

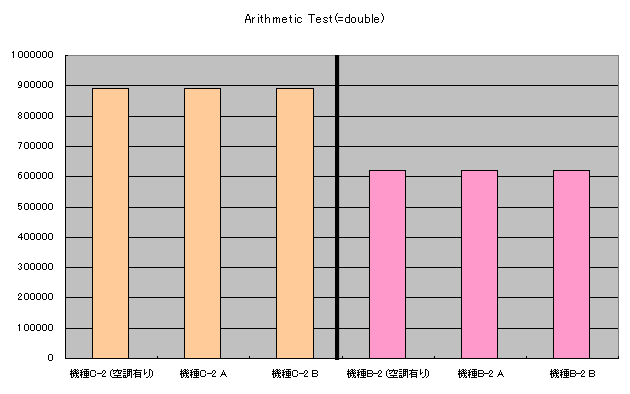

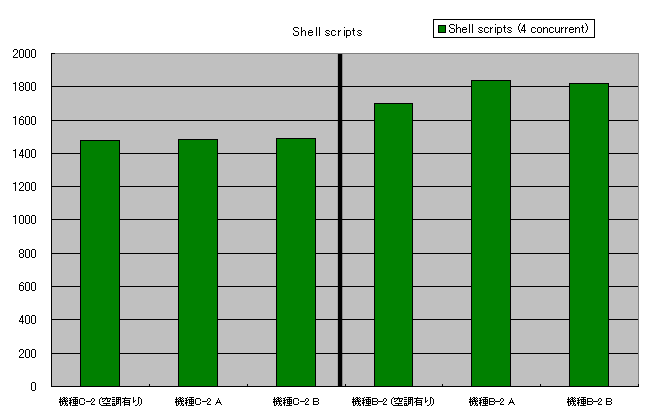

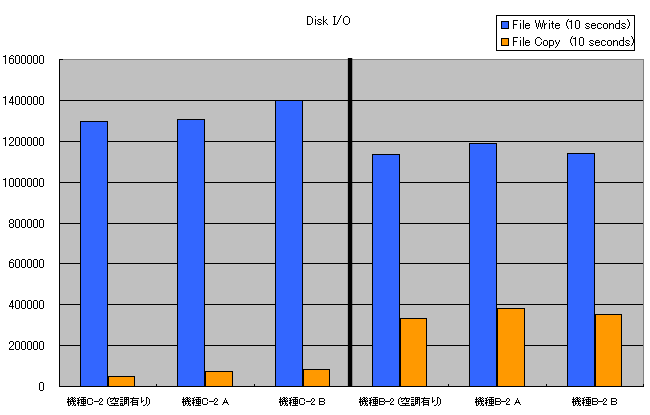

室温上昇によるパフォーマンスの劣化は大きくなさそう。

結果を踏まえ

現在のデータセンタのコロケーションの室温は25度前後ですが、本試験により35度にすることも可能。

ただし...

メーカ、機種により閾値はバラバラなので、必ず確認。

負荷ピーク時でも35度を超えないような設定にしないとダメ。

もう一歩踏み込んで、空調設備をまったく使わなくするには、

「外気」を使い、コロケーション内温度を調整することも可能かと思います。

例えば、日本の北側(寒冷地)にデータセンタを置くと、大きく空調設備を打たずに運用可能といえるかと思います。

なお、最近は吸気温度が低すぎると壊れる機器もあるようなので、冷やしすぎにもご注意ください。

こちらの記事のご感想を聞かせください。

- 学びがある

- わかりやすい

- 新しい視点

ご感想ありがとうございました